OpenAI GPT-4o图像生成功能升级,AI图像生成技术再突破

AI导读:

OpenAI在凌晨直播中更新了GPT-4o和Sora,推出图像生成功能,强调精准理解和生成文本优势。功能已向部分用户开放,计划未来扩展。国内豆包、智谱AI也在文生图领域有所进展,但仍面临挑战。OpenAI计划未来推出GPT-5。

图像生成领域取得了新进展,OpenAI在解决“生成图像中的文字”这一难题上取得了突破。北京时间3月26日凌晨,OpenAI进行了直播,更新了GPT-4o和Sora,并在ChatGPT和Sora中推出了GPT-4o的图像生成功能。此次,OpenAI特别强调了新功能在精准理解文本描述和准确生成图像文字方面的优势。

据OpenAI介绍,GPT-4o的图像生成功能非常擅长准确呈现文本描述,并能严格遵循用户的提示词。此外,该功能还将GPT-4o的知识库和聊天上下文作为灵感来源,这极大地提升了用户与图像生成工具之间的沟通效率,并显著提高了生成图像的质量。目前,该功能已向ChatGPT Plus、Pro、Team和免费用户开放,并计划未来向企业、教育和API用户推出。

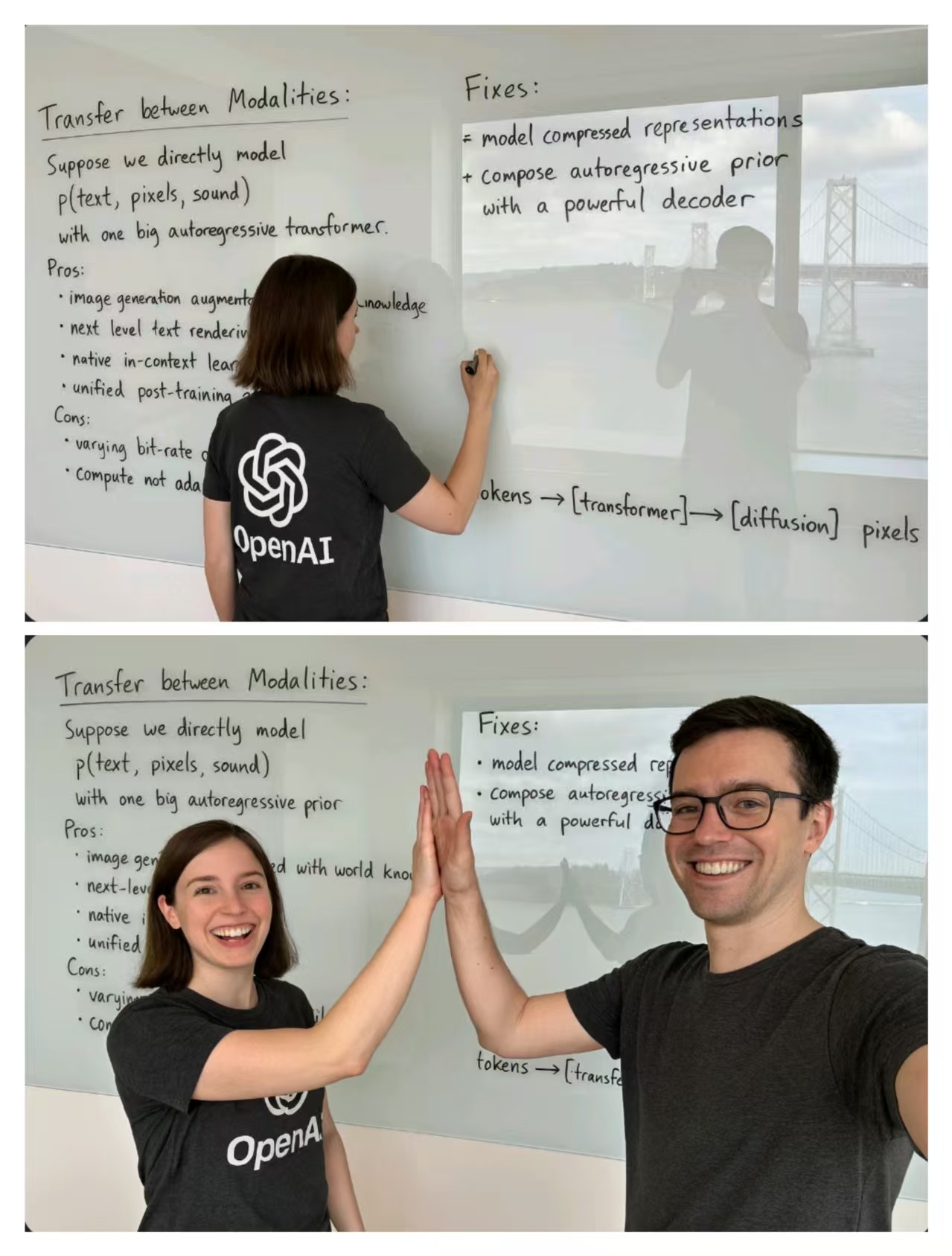

在OpenAI的演示中,要求大模型生成一张图片,内容为一名女子在俯瞰海湾大桥的房间内用笔在白板上写字,衣服上印有OpenAI字样,白板还映出了摄影师的身影,并详细描述了白板上所写的文字。GPT-4o生成的图像完全符合这些要求。随后,OpenAI要求摄影师走到镜头前与女子击掌,GPT-4o同样成功呈现了这一画面,且白板上的文字保持清晰,女子的身形和发型也与前一张图像一致。

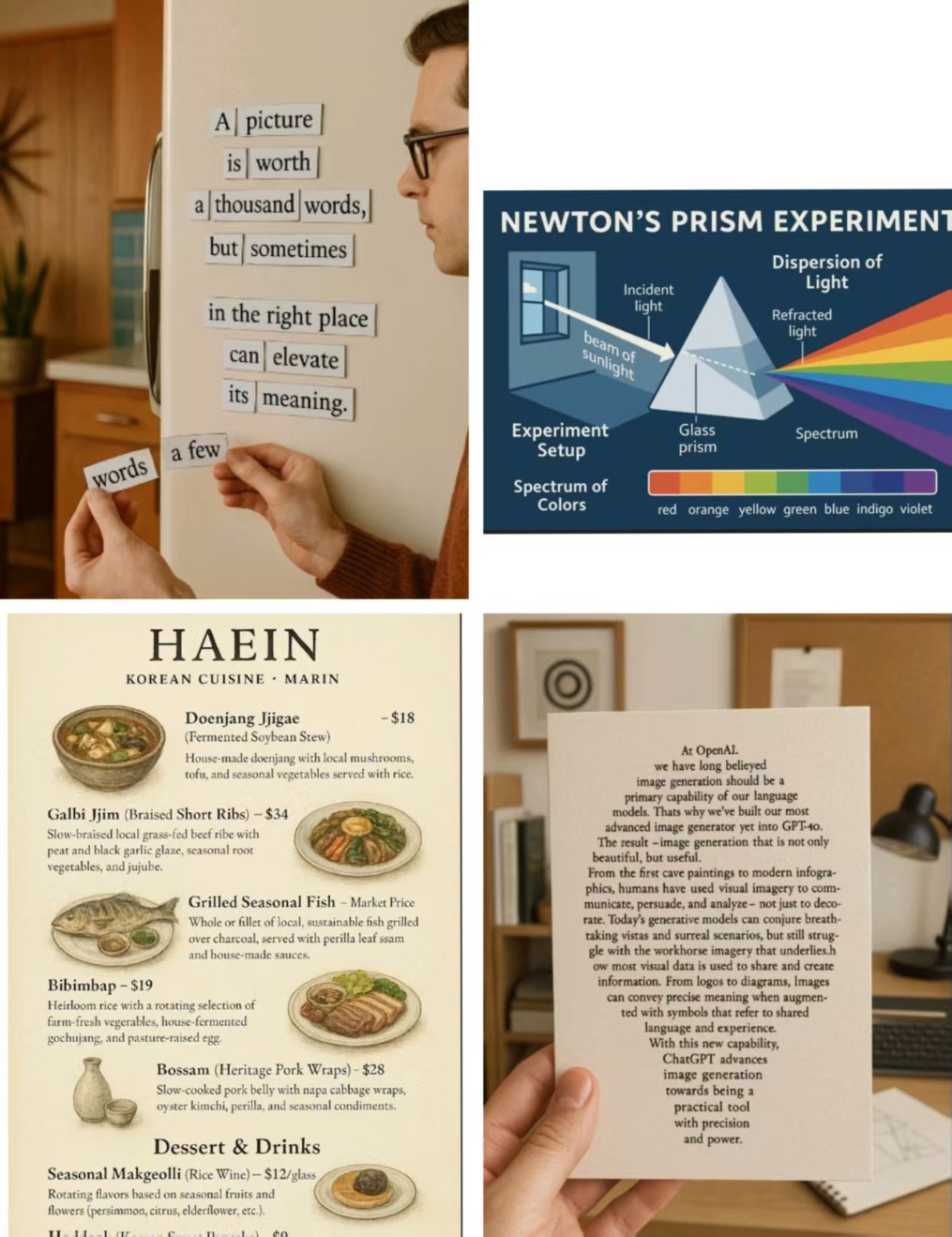

在其他演示中,OpenAI要求大模型生成上世纪中叶一个家庭中冰箱上贴着的诗歌短句,并要求画面中的人手拿着特定的几个词,GPT-4o精准还原了场景。此外,GPT-4o还能根据准确的情节描述生成漫画。OpenAI还展示了该图像生成功能在科学实验中的用途,如生成牛顿棱镜实验的示意图。同时,该功能在生成路牌、菜单、游戏画面以及鸡尾酒配方、天气信息图像等方面也表现出色,能够生成专业的配方和天气文本描述。

关于GPT-4o图像生成功能的训练,OpenAI表示,他们使用了网络上的图像和文本数据来训练模型,使模型能够学习图像与文字、图像与图像之间的关系,从而具备视觉流畅性,生成有用且上下文连贯的图片。

在功能特点方面,OpenAI指出,用户可以通过自然对话与大模型交流,要求改进图像,过程中图像中的人物等要素会保持一致。此外,用户与大模型的交流更加顺畅,可以同时要求处理10到20个不同的对象,使图像中各要素呈现出相关性。相比之下,其他图像生成系统通常只能同时处理5到8个对象。

然而,OpenAI也承认GPT-4o的图像生成功能存在一些限制,如可能出现幻觉、难以呈现过多依赖知识库的图像要素、图表准确性不足、呈现非拉丁语言时可能出现幻觉以及在要求修改图像中的错别字时难以精准编辑。

生成图像中的文字一直是图像生成领域的一个挑战。在国内,去年豆包升级了文生图能力,支持一键生成指定文本。今年3月,智谱AI发布了首个支持生成汉字的开源文生图模型CogView4。不过,相关模型在生成文字方面的稳定性仍有待提升。

3月26日,记者试用豆包APP和智谱清言APP生成图像。其中,智谱清言使用的是CogView4模型。在输入指定文本后,智谱清言生成的海报中出现了一些乱码。而豆包虽然生成的中文文字准确,但对文本的理解有所偏差。在调整提示词后,豆包呈现出了正确的日期和主题字样,但仍有一些字是乱码,智谱清言也生成了乱码。

在更新GPT-4o的图像生成功能后,OpenAI下一步的重大产品更新将是推出GPT-5。今年2月,OpenAI首席执行官山姆·奥尔特曼透露,他们将在ChatGPT和API服务中搭载新模型GPT-5。GPT-5将集成公司的多项技术,包括推理模型o3的技术,并有望在未来几个月内推出。

(文章来源:第一财经)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。