DeepSeek公布AI模型成本利润率高达545% 引发行业关注

AI导读:

DeepSeek团队在知乎发布动态,公布AI模型的优化技术细节和成本利润率,理论成本利润率高达545%。这一利润率引起了AI行业的广泛关注,并促进行业学习和发展。

持续五天的“Deepseek开源周”刚结束,DeepSeek团队就在国内知乎平台注册官方账户,并在3月1日发布了第一条动态。这篇最新的帖子首次公布了模型的优化技术细节、成本利润率等关键信息。

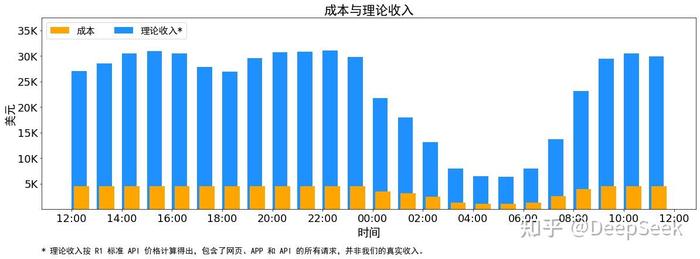

据DeepSeek测算,假定GPU租赁成本为2美元/小时,总成本为8.7万美元/天。若将所有模型tokens按DeepSeek-R1的定价计算,理论上一天的总收入为5.62万美元,成本利润率高达545%。这一利润率在AI行业引起了广泛关注。

高达545%的利润率对AI行业意味着什么?界面新闻采访了复旦大学计算机科学技术学院教授张奇。张奇教授指出,在自然语言处理中,Token是基本单位,AI处理每个Token都需要消耗算力。DeepSeek提到的56.3%缓存命中率是一项具有重要意义的数据,显示其在模型优化上做了大量工作。

DeepSeek团队介绍,V3、R1推理系统的优化目标是追求“更大的吞吐,更低的延迟”。基于混合专家模型核心架构(MOE),DeepSeek实现了“大规模跨节点专家并行”,提高了模型运行效率。

此外,DeepSeek还实现了一套机制,在白天用户访问量大时,利用所有模型节点部署推理服务;晚上则减少推理节点,用于研究和训练。这一策略进一步提高了资源利用率。

图源:DeepSeek知乎官方账号

图源:DeepSeek知乎官方账号

根据DeepSeek统计,在最近的24小时内,将DeepSeek V3和R1推理服务占用节点加到一起,高峰期最多占用278个节点,平均占用226.75个节点。考虑到DeepSeek还有其他工作需要GPU,这些GPU大概率已经用上了现阶段为DeepSeek V3与R1模型所能调用的“全部算力资源”。

DeepSeek的创新在于在有限资源下将效率提升至极致,实现了低成本开发。在此基础上,才实现了545%的成本利润率。但DeepSeek也强调,545%只是一个理论值,实际运行时收入会受多种因素影响。

图源:DeepSeek知乎官方账号

图源:DeepSeek知乎官方账号

此前,DeepSeek就因“AI拼多多”的低价标签备受关注。此次公布的高利润率也让外界看清了DeepSeek降价的“底牌”。DeepSeek创始人表示,公司的定价策略是在成本之上保留一定的利润空间,不追求过高利润。

目前,业内宣布接入部署DeepSeek R1模型的厂商大多以小规模设备为主。而DeepSeek团队所实现的300多台服务器部署工程对团队技术能力要求极高。尽管545%的成本利润率是理论值,但依然让行业看到了“赚钱的希望”。

张奇教授认为,DeepSeek开源模型优化方法将促进行业学习和发展。虽然将同样优化方法落到实际会遇到各种新问题,但整个行业会在这方面进行更多尝试。

(文章来源:界面新闻)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。