DeepSeek引发行业关注,AI幻觉问题亟待解决

AI导读:

DeepSeek频频上热搜,AI幻觉风险变高,金融行业等受冲击。业内人士表示,现有技术无法彻底消除AI幻觉,“AI生成初稿+人类核查”或将成为主流选择。大模型提高效率,但AI幻觉问题未解决,需探索应对策略。

最近一段时间,“Deepseek化身中医开药方”“DeepSeek搞钱指南”等词条频频上热搜,引发医疗、金融等行业从业者的关注。在AI技术日新月异的今天,“一路开挂”的DeepSeek真的这么神吗?

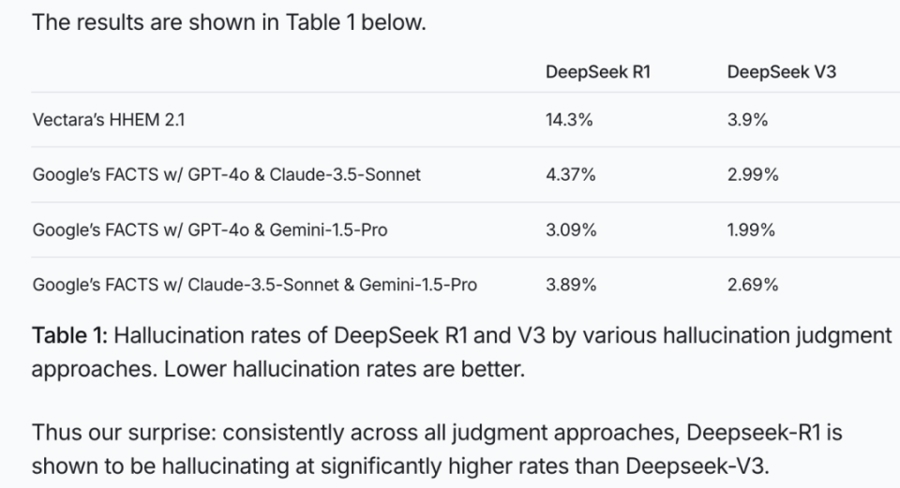

事实上,国内不少行业正在加强生成式AI以及大模型应用的监管,尤其是推理模型成为新趋势后,AI幻觉风险反而变高了。测试结果显示,DeepSeek-R1推理模型的幻觉率远高于大语言模型V3。业内人士表示,现有的技术条件无法彻底消除AI幻觉,“AI生成初稿+人类核查”或将成为未来的主流选择。

DeepSeek冲击力暂时有限

前几天,社交媒体上有医学博主自曝称,有病人咨询了DeepSeek后质疑医生的诊疗方案,但经过医生自查,发现DeepSeek的诊断结果与最新的治疗方案一致。

除了医学,DeepSeek也给金融业带来了不小冲击。在各大社交平台上,“DeepSeek搞钱指南”等热门词条下,不少博主分享利用DeepSeek投资理财的经验,评论区中则全是索要提示词的留言。然而,随着DeepSeek不断接入各大平台,“AI问诊”“AI理财”等应用层出不穷,用户需求激增的同时,监管也在逐渐收紧,尤其是医疗、金融等强监管行业。

比如湖南医保局明确互联网医院严禁使用人工智能自动生成处方,国家卫健委也对人工智能问诊作出限制规定,将处方权限制在医师手中。在金融行业,虽然一些金融大模型早已深入行业操作流程中,但针对敏感文件报送、高频交易、衍生品定价等低容错的环节,仍依赖人工审核。

“大模型能够提高效率,但AI幻觉问题仍未解决。越是高风险行业,对AI幻觉的容忍度越低。毕竟AI一旦胡说八道,带来的都是真金白银的损失。”上述证券机构从业者表示。

推理能力与幻觉风险正相关

“大模型的推理能力非常强,方向也很宽泛,可能在‘思考过程’中就存在两个相冲突的逻辑,但在最终的总结生成时,有可能会把两个相悖的答案‘捏’在一起。”信美人寿相互保险社数据信息中心负责人童国红告诉记者,大模型“一本正经地胡说八道”一方面是推理过程中出现幻觉,另一方面是训练数据的缺失。大模型的“认知能力”完全依赖于训练数据,如果提供的训练数据遗漏了和业务相关的重要信息,或是存在错误信息,大模型生成的内容也会出错。

国内某头部AI企业技术人士表示,幻觉是大模型技术原理的固有缺陷,大模型基于概率预测生成文本,当信息缺失时,会通过“合理推测”填补空白,特别是一些推理模型在回答开放性问题时,常虚构细节以保持逻辑连贯。另外,庞大参数导致模型记忆训练数据中会出现“噪声”,面对新问题时难以准确泛化,易产生上下文矛盾或事实错误。

AI大模型在行业落地时,小小的幻觉会导致“差之毫厘谬以千里”的后果。

童国红举例:用户要求比较两款保险产品的现金价值增长情况,通过调用保险专业工具,正确的计算结果应该是——在第30个保单年度时,A款产品的现金价值为1836360元,B款产品的现金价值为2145000元,A比B低14.39%。而在同样的指令下,大模型的输出结果却截然相反,导致用户误解。

随着DeepSeek等推理模型的增强,AI思考能力更强了,但能否缓解AI幻觉的概率?面对记者提问,上述技术人员仍给出了否定的答案。

“推理模型通过强化逻辑框架提升了复杂问题解决能力,但幻觉问题并未缓解,甚至在处理开放性问题时,会强行构建逻辑链,导致虚构事实。”他援引一项模型幻觉测试结果称,谷歌Gemini 2.0 Flash的幻觉率仅0.7%,而DeepSeek R1高达14.3%,表明推理能力与幻觉风险呈正相关,目前技术仅能通过优化训练策略(如混合训练)局部改善,无法彻底解决。

测试显示,DeepSeek-R1幻觉率高达14.3%。

AI是效率工具而非终端决策

虽然短期内无法杜绝AI幻觉,但不少行业在落地应用时正探索出一些应对策略,要么减少AI幻觉的概率,要么将AI幻觉关进“笼子”。

据介绍,优化提问方式、多模型交叉验证、事实核查工具和人工干预等,都是业内主流的应对策略。目前,检索增强生成(RAG)成为大模型行业的共识,比如百度的检索增强的文生图技术(iRAG),可以解决大模型在图片生成上的幻觉问题。未来可能将形成“AI生成初稿+人类核查”的标配流程,将AI作为效率工具而非决策终端。

以信美发布的大模型保险垂直应用“信美Chat-Trust3.0”为例,通过多重机制减少AI幻觉带来的负面影响。首先,在输出端多加一步,使用另外一个模型去校准答案,也称为“反思机制”。通过引入另一个模型,对本次得出的结论进行“二次检验”。比如评估生成内容是否有悖于常识或者已知信息、逻辑是否清晰合理,同时检验输出内容是否涵盖了任务的全部要求等。

在上述对比保单现金价值的案例中,信美就是通过引入另外一个模型纠正了计算结果。

同时,给AI“喂料”更加精准、合适的数据。在实际应用中,除了行业内使用的通用大模型基座外,不同企业会有不同的知识库。如何在使用通用大模型的基础上,在垂类大模型的应用竞争中脱颖而出,关键就在于根据自身业务特色,给出最关键和精准的数据。

童国红人表示,目前“信美Chat-Trust3.0”正在内测核保辅助支持功能,正确率在70%—80%,距离90%的交付要求,还有一小段距离。“乐观估计,今年年内可以推向外部。想要大范围推广一个大模型应用,必须要保证,机器生成的结果比人的正确率高。AI幻觉是持续要解决的问题。”

(文章来源:上观新闻)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。