DeepSeek开源FlashMLA,突破GPU算力瓶颈加速AI发展

AI导读:

DeepSeek开源首个代码库FlashMLA,专为处理可变长度序列设计,突破GPU算力瓶颈,加速AI行业发展。DeepSeek秉持开源精神,与全球开发者分享研究进展,其开源模型将降低AI应用成本,提升算力需求。

万众瞩目的Deepseek“开源周”,第一弹来了。

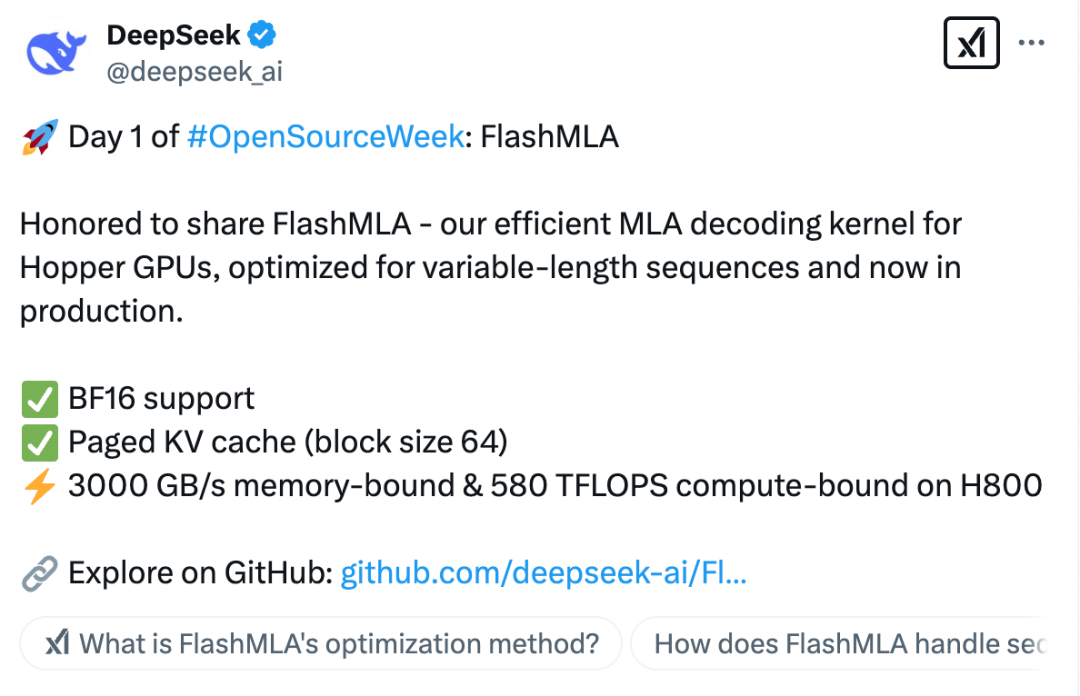

2月24日,DeepSeek开源了首个代码库FlashMLA。据了解,这是DeepSeek针对Hopper GPU优化的高效MLA(Multi-Head Latent Attention,多头潜在注意力)解码内核,专为处理可变长度序列而设计,现在已经投入生产使用。这一举动在AI领域引起了广泛关注,成为“开源周”的精彩开篇。

上周四,DeepSeek宣布将在本周举办“开源周”活动,连续开源五个代码库,这一消息立即点燃了业界的期待。作为“开源周”的第一弹,FlashMLA无疑给业界带来了不少惊喜。在接下来的四个工作日,DeepSeek还将继续开源四个代码库,预计这些代码库将涉及AI算法优化、模型轻量化、应用场景拓展等关键领域。

进一步突破GPU算力瓶颈

FlashMLA实现了以下突破:

一是BF16支持,提供更高效的数值计算能力,同时优化存储带宽使用率。

二是分页KV(Key-Value)缓存,采用高效的分块存储策略,提高缓存命中率,从而提升计算效率。

三是极致性能优化,在H800GPU上,FlashMLA通过优化访存和计算路径,达到了高性能计算标准,进一步突破GPU算力瓶颈。

FlashMLA通过动态调度和内存优化,最大化利用GPU资源,尤其适用于高性能AI任务,能够降低成本。

DeepSeek提出的创新注意力架构MLA,实现了大模型训练与成本的大幅降低。MLA通过压缩注意力机制矩阵,减少参与运算的参数数量,从而在保持模型性能的同时显著降低了计算和存储成本。

浙江大学计算机科学与技术学院和软件学院党委书记、人工智能研究所所长吴飞表示,DeepSeek引入低秩概念,极大提升了模型运行效率。

由于Flash MLA进一步突破了GPU算力瓶颈,英伟达股民对DeepSeek寄予厚望,希望其能助力GPU高效运行,同时不影响股价。

以持续开源 加速行业发展进程

作为开源社区的“顶流”,DeepSeek以完全透明的方式与全球开发者社区分享最新的研究进展,致力于加速行业发展。

DeepSeek表示,作为开源社区的一部分,每分享一行代码,都将为AI行业发展贡献一份力量。其秉持纯粹的车库文化和社区驱动的创新理念,赢得了业界的广泛赞誉。

DeepSeek的开源精神得到了网友的热烈响应。有网友称赞其公开透明,甚至有人预测“开源周”第五天将推出通用人工智能。

据证券时报记者了解,开源代码促进会针对AI提出了三种开源概念,分别是开源AI系统、开源AI模型和开源AI权重。DeepSeek此前属于第三种类型的开源,但其开源程度已经是最顶级、最彻底的一种。

民生证券研报认为,DeepSeek所有模型均为开源模型,这将加速AI应用的发展进程。从更长的周期来看,DeepSeek的发展将带来算力需求、特别是推理算力需求更大量级的提升。

(文章来源:证券时报·e公司)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。