国产AI公司DeepSeek发布NSA论文,引领稀疏注意力技术革新

AI导读:

2月18日,国产AI公司DeepSeek发布关于NSA(原生稀疏注意力)的论文,解决大模型在处理长文本时的计算挑战。实验表明,使用NSA预训练的模型表现优异,且处理速度显著提高。DeepSeek的爆发正重塑中国大模型行业。

2月18日,大洋彼岸的马斯克展示最新大模型Grok 3之际,国产AI公司深度求索(Deepseek)的一篇关于NSA(Natively Sparse Attention,原生稀疏注意力)的论文引发广泛关注。该论文由创始人梁文锋等人在2月16日提交至预印本平台arxiv。

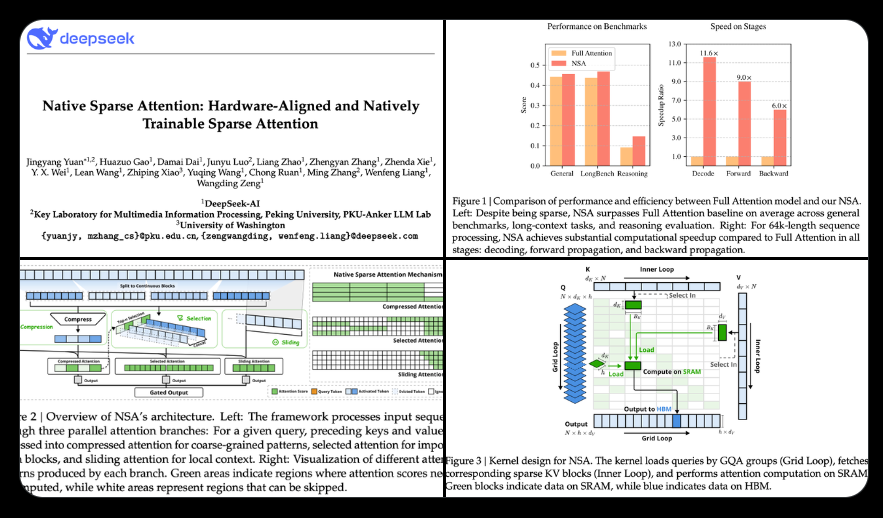

论文指出,上下文建模对下一代语言模型至关重要,但标准注意力机制的高计算成本带来了巨大挑战。NSA通过提高效率,为模型能力提供新方向,实现算法创新与硬件优化结合,高效建模长上下文。DeepSeek采用动态分层稀疏策略,结合粗粒度标记压缩与细粒度标记选择,保持全局上下文感知和局部精度。

实验表明,使用NSA预训练的模型在基准测试、长上下文任务和指令推理中表现优异,且相比全注意力机制在64k长度序列解码中实现显著加速。业内人士评论称,此次论文发布解决了DeepSeek-R1在输入上下文能力方面的不足,对复杂数学推导非常有价值。

据悉,DeepSeek此次聚焦于大模型最核心的注意力机制。Transformer架构作为大模型基础,其注意力机制在处理长文本时存在瓶颈。NSA新架构相比传统注意力机制,准确率相同或更高,处理64k标记序列时速度可提高至11.6倍,且训练更高效,算力消耗更少。

论文作者中,梁文锋位列倒数第二,第一作者为北京大学硕士研究生袁景阳。值得注意的是,梁文锋的训练思路与马斯克截然不同,更注重在更少算力下达到更好效果。同时,国内另一大模型公司“月之暗面”也发布类似稀疏注意力框架MoBA,旨在提高长文本处理效率。

随着DeepSeek等国产AI公司的崛起,AI竞赛日益加剧。DeepSeek推出的大模型DeepSeek-R1在数学、代码等领域性能卓越,并采用MIT许可协议支持免费商用。春节假期后,多个行业龙头公司宣布接入DeepSeek。DeepSeek的爆发正重塑中国大模型行业,关注技术性价比与商业化闭环。

(文章来源:澎湃新闻)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。