DeepSeek发布原生稀疏注意力机制NSA技术报告

AI导读:

DeepSeek在海外社交平台发布关于NSA技术的纯技术论文报告,旨在提高推理速度并降低预训练成本。NSA通过针对现代硬件的优化设计,在多个测试中均能达到或超越全注意力模型的表现,扩展了大语言模型的应用边界。

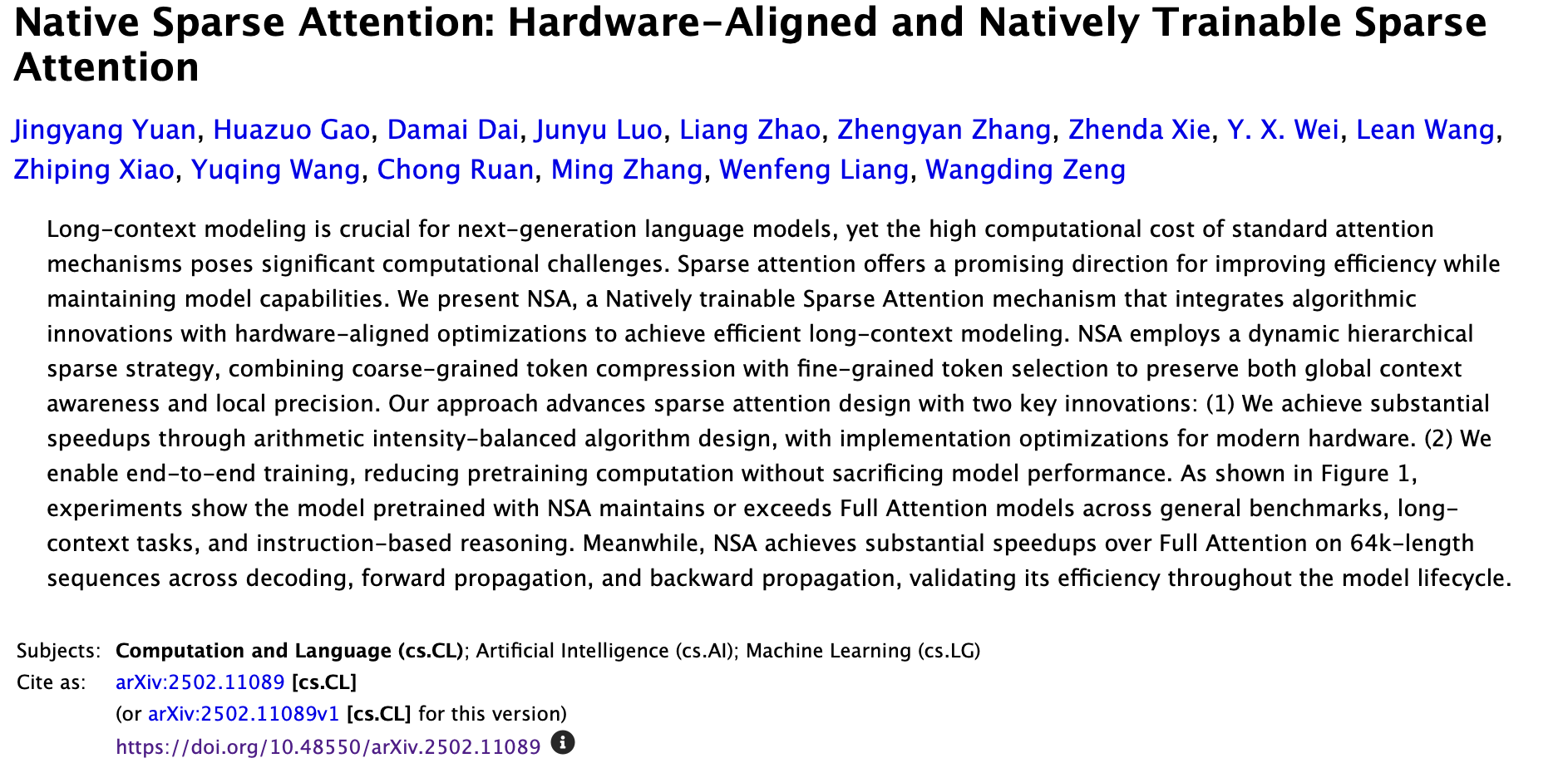

2月18日,Deepseek在海外社交平台发布了一篇关于NSA(Natively Sparse Attention,原生稀疏注意力)的纯技术论文报告。NSA是一种专为超快速长文本训练与推理设计的、硬件对齐且可原生训练的稀疏注意力机制,旨在提高推理速度并降低预训练成本,而不牺牲性能。

DeepSeek团队表示,NSA通过针对现代硬件的优化设计,在通用基准测试、长文本任务和基于指令的推理中,均能达到或超越全注意力模型的表现。这种稀疏注意力机制为提高效率同时保持模型能力提供了一个有前景的方向。

值得注意的是,DeepSeek创始人梁文锋也是这篇名为《原生稀疏注意力:硬件对齐且可原生训练的稀疏注意力机制》的论文的署名作者之一。

论文摘要指出,业界已逐渐认识到长上下文建模对于下一代大型语言模型的重要性。然而,随着序列长度的增加,标准注意力机制的高复杂度成为了关键的延迟瓶颈。NSA通过高效的长序列处理能力,扩展了大语言模型在文档分析、代码生成、复杂推理等领域的应用边界。

有网友评论称,“稀疏注意力机制确实能减少计算开销,DeepSeek的NSA架构虽然新颖,但在实际部署中,还需考虑具体应用场景和硬件优化。”(文章来源:上海证券报·中国证券网)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。