生成式AI应用深化,数据安全与立法成焦点

AI导读:

2024年,生成式AI技术广泛应用,引发数据安全、版权归属等问题。第八届啄木鸟数据治理论坛聚焦AI应用落地与向善治理,发布测评报告。报告指出,近九成受访者对AI风险有认识,但深入了解者较少。公众呼吁通过立法保护数据安全与隐私。

2024年,大模型浪潮加速推进,生成式AI技术广泛融入人们的日常生活,成为工作、创作和娱乐的重要助手。然而,AI技术与各行业深度融合的同时,也引发了数据安全、版权归属、伦理挑战等一系列问题。12月18日,南都数字经济治理研究中心联合清华大学智能法治研究院主办的第八届啄木鸟数据治理论坛在京举行,围绕“AI应用落地提速,如何向善治理”展开探讨。

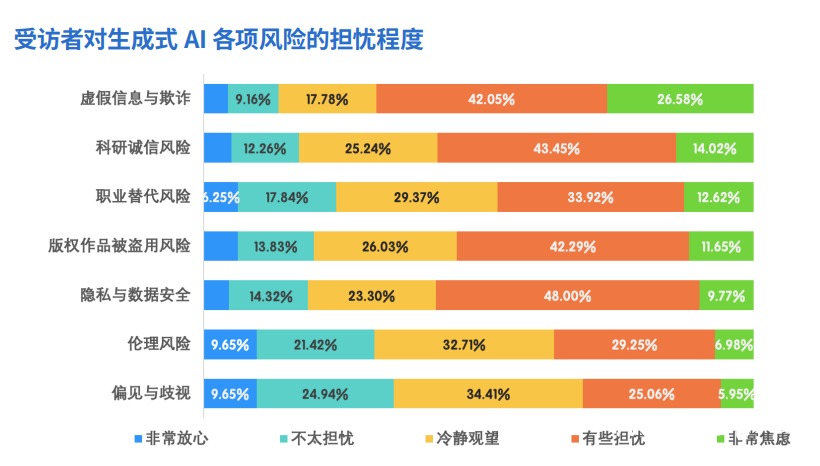

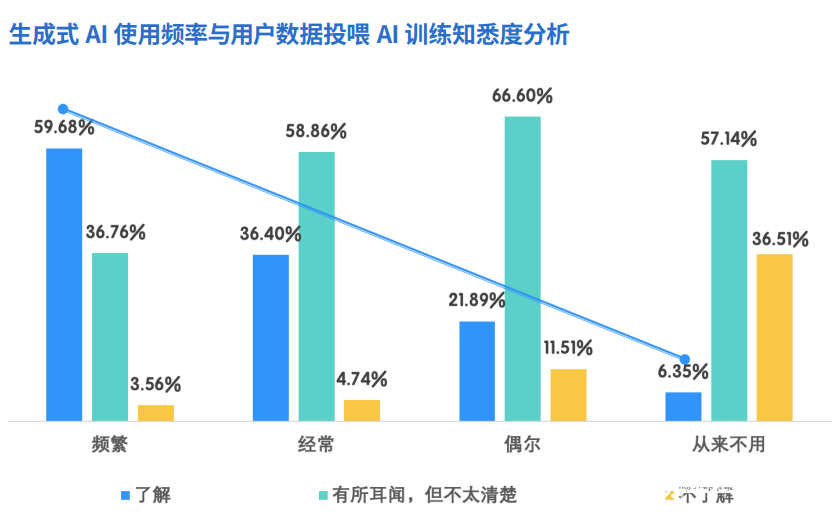

会上,南都数字经济治理研究中心发布了《生成式AI用户风险感知和信息披露透明度测评报告(2024)》。报告显示,近九成受访者对生成式AI的潜在风险有一定认识,但深入了解的比例较低。虚假信息与欺诈、隐私与数据安全、科研诚信风险、版权作品被盗用等问题备受关注。此外,报告还指出,超六成受访者高频使用生成式AI,且使用频率越高,对潜在风险的了解程度也越高。

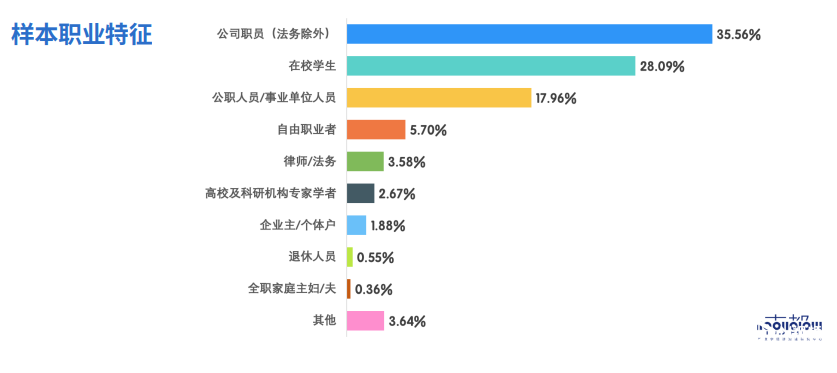

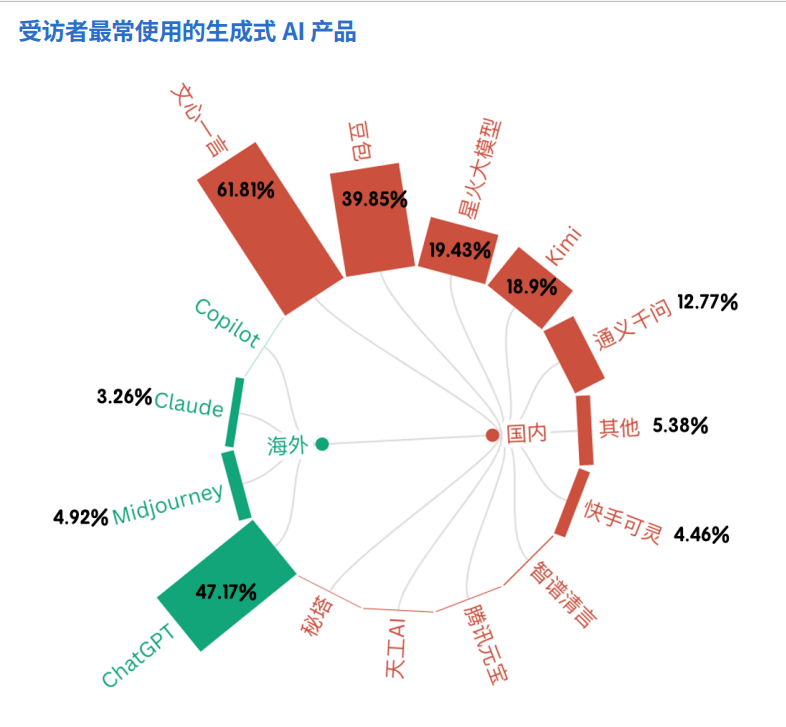

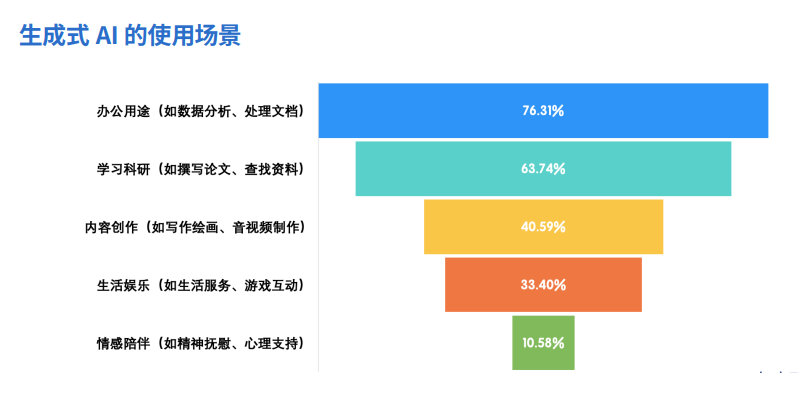

问卷数据显示,百度文心一言、ChatGPT、字节豆包等生成式AI产品备受用户青睐。受访者使用生成式AI主要用于办公场景和学习科研场景,占比分别接近八成和六成。在内容创作和生活娱乐方面也有一定应用,但情感陪伴的使用比例较低。

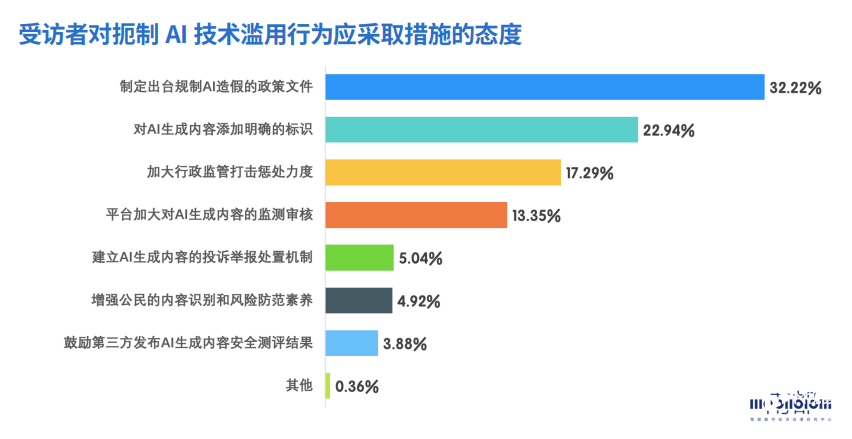

在内容质量评价方面,受访者认为生成式AI最值得信任的是文本内容的真实性和逻辑性,对话的自然性和互动性也备受认可,但绘画、音频和视频生成的质量相对较低。同时,大多数受访者对生成式AI潜在风险略有了解,但深入了解的比例较低。对于AI深度合成技术被滥用的问题,支持通过立法以及对生成内容添加明确标识的人数最多。

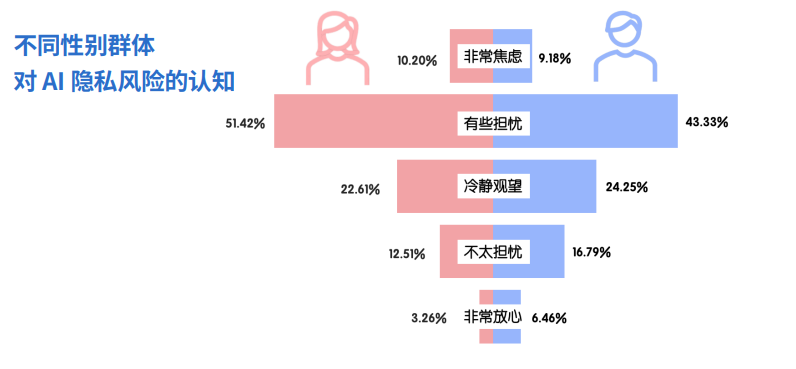

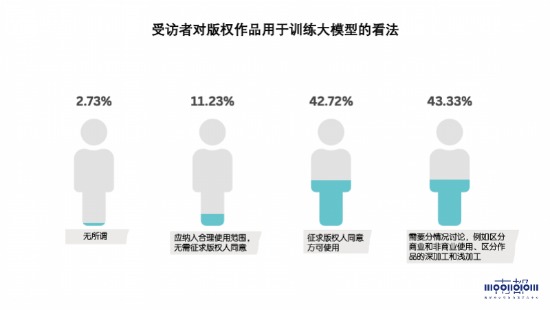

在隐私数据安全风险方面,约三成受访者了解网络平台利用个人数据训练大模型,且使用大模型服务频率越高以及学历越高的受访者,对平台利用个人数据训练大模型的情况更为了解。大多数用户并不排斥将数据免费提供给网络平台使用,但前提是平台作出具体说明且保护好个人数据。对于版权作品用于训练大模型的看法,大多数人认为必须征得版权人同意方能使用。

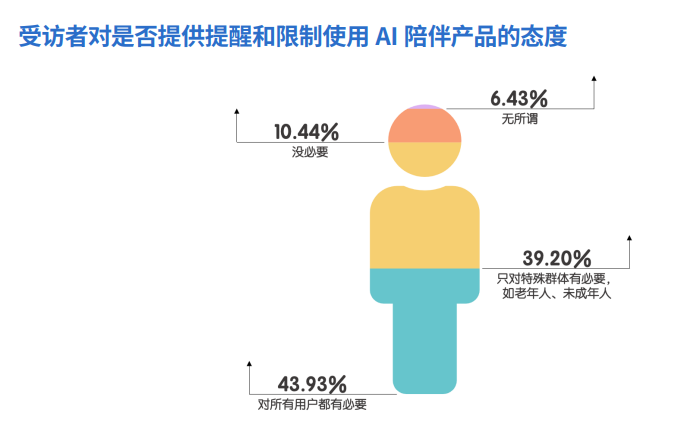

此外,报告还就AI陪伴产品的潜在风险进行了分析。超过八成受访者听说过满足情感需求的AI陪伴产品,但公众对AI陪伴产品能带来的情感交互体验持保留态度的居多。大多数受访者认为应对所有AI陪伴产品用户作出提醒和限制。

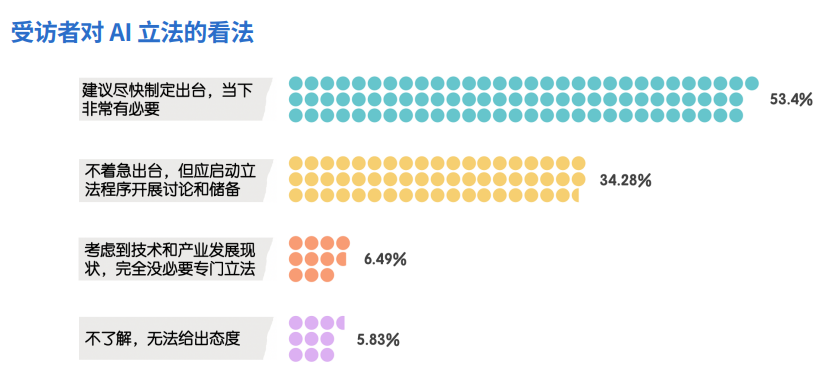

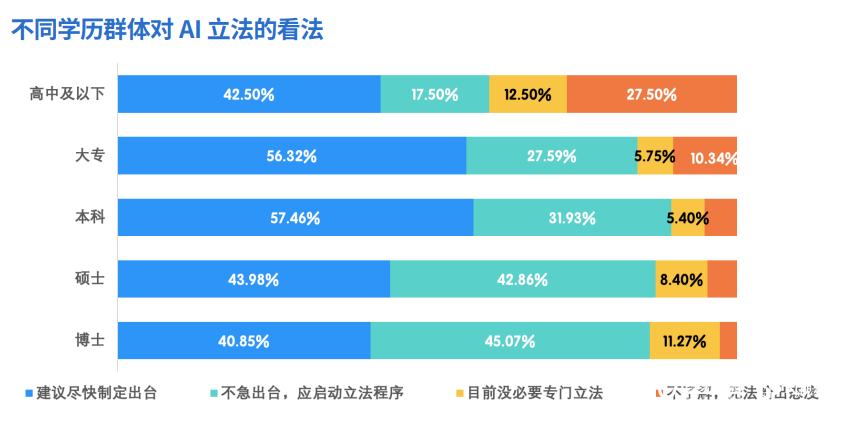

随着公众对生成式AI潜在风险的关注加深,越来越多受访者认为应通过专门的法律来应对隐私保护、数据安全以及AI带来的伦理挑战等问题。近九成受访者对AI立法持积极态度,其中超过一半受访者认为应尽快制定专门的法律框架。

值得注意的是,人工智能立法已被我国立法部门提上日程。全国人大常委会和国务院的年度立法工作计划均将人工智能立法列入预备审议项目,国家网信办副主任也专门回应了人工智能立法的热点问题。

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。