阿里云大模型价格战升级,通义千问视觉理解模型大幅降价

AI导读:

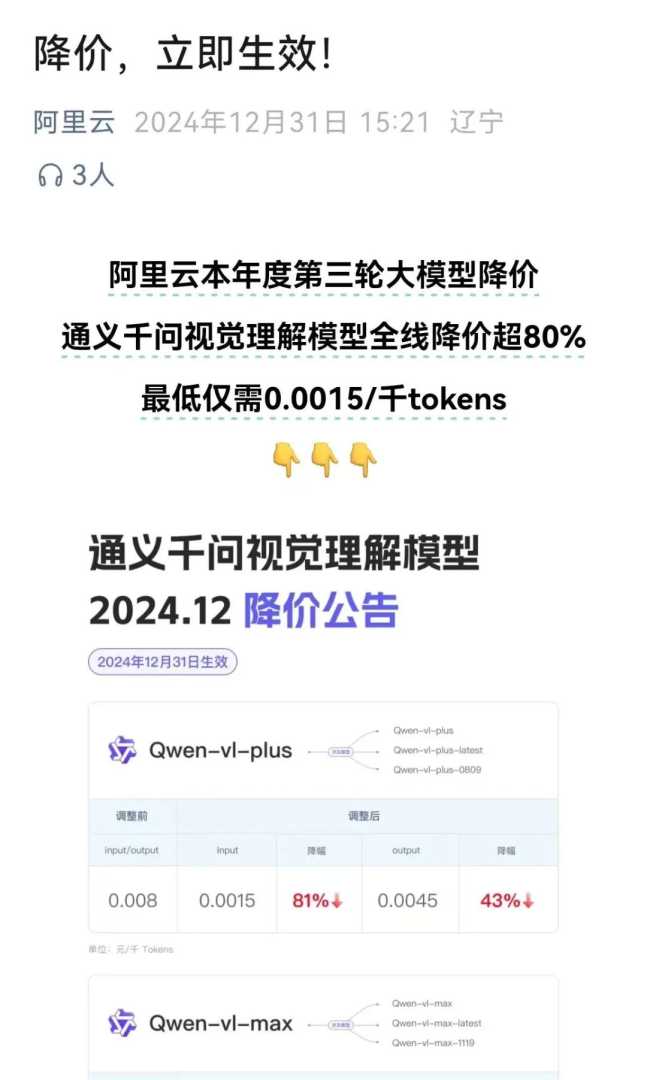

阿里云宣布通义千问视觉理解模型全线降价超过80%,其中Qwen-VL-Plus和Qwen-VL-Max降价幅度分别高达81%和85%,旨在第一时间将技术红利释放给所有用户。

大模型市场的价格战再次掀起波澜。

在字节跳动旗下豆包视觉理解模型于12月18日大幅降价至0.003元/千Tokens之后,阿里云于12月31日迅速响应,宣布通义千问视觉理解模型全线降价超过80%,且降价措施立即生效!

这是阿里云在2024年内继5月和9月之后的第三轮大模型降价举措。

具体而言,Qwen-VL-Plus的降价幅度达到81%,其输入价格降至0.0015元/千tokens,这一价格创造了全网最低价;而高性能版本的Qwen-VL-Max也降至0.003元/千tokens,降价幅度高达85%。

根据阿里云此次降价后的最新定价,用户仅用1元钱即可处理大约600张720P分辨率的图片,或1700张480P分辨率的图片,这一性价比极具吸引力。

相比之下,在豆包大模型降价后,用户1元钱仅能处理284张720P分辨率的图片。

Qwen-VL作为开源社区中备受青睐的多模态大模型,以其卓越的视觉推理能力脱颖而出。它能够识别各种分辨率和长宽比的图片,理解长达20分钟以上的长视频,并具备自主操作手机和机器人的视觉智能能力,适用于手机、汽车等多种终端的视觉识别场景。

阿里云百炼团队的负责人表示:“此次降价主要得益于阿里云在基础设施和模型结构方面的持续优化,以及大模型调用量指数型增长所带来的规模效应。我们致力于第一时间将这些技术红利传递给所有用户。”

在推理效率方面,阿里云通过构建极致弹性的AI算力调度系统,并结合百炼分布式推理加速引擎,显著降低了模型推理成本,并加速了模型推理过程。

自2024年以来,随着通义千问团队对视觉理解效果的持续优化,Qwen-VL已成为百炼平台上增长最为迅速的模型之一。

此外,为了进一步降低用户使用文本大模型API的成本,阿里云百炼还推出了全新的KV Cache计费模式。这一模式通过自动缓存上下文来避免重复计算,从而进一步降低了模型调用成本,特别适用于长文本处理、代码补全、多轮对话以及特定文本摘要等场景。

(文章来源:中国基金报)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。