微软开源Deep Speed Chat,人工智能商业化迎来变革

AI导读:

微软宣布开源大语言模型训练工具Deep Speed Chat,旨在帮助用户轻松训练类ChatGPT等大语言模型,此举将大幅降低大模型训练门槛,推动人工智能技术的普及和商业化变革。

人手一个ChatGPT的时代或许就要来了!

人工智能行业再次迎来重大突破。当地时间4月12日,微软宣布将开源大语言模型训练工具Deep Speed Chat,这一消息紧随OpenAI开放GPT的API之后,为更多用户提供了接触和使用底层训练工具的机会。

微软开源Deep Speed Chat

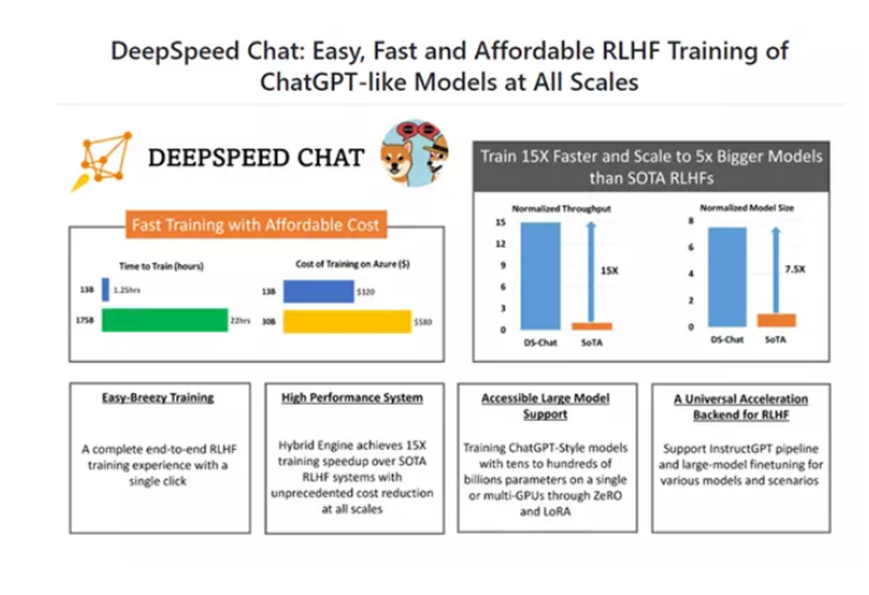

当地时间4月12日,微软正式推出了Deep Speed Chat,这一工具基于微软Deep Speed深度学习优化库开发,旨在帮助用户轻松训练类ChatGPT等大语言模型。它不仅具备训练、强化推理等功能,还融入了RLHF(人工反馈机制的强化学习)技术,实现了训练速度的大幅提升,成本却显著降低。

Deep Speed Chat通过提供接近“所见即所得”的反馈机制,使得即便是没有深厚人工智能模型训练背景的用户,也能在短时间内快速训练出定制化的ChatGPT大语言模型,为用户提供了极大的便利。

据微软透露,使用该工具训练一个130亿参数的类ChatGPT模型,仅需1.25小时;而对于一个1750亿参数的模型,训练时间也不到一天,这一参数规模与ChatGPT-3.5相当。这一工具的出现,无疑将大幅降低大模型训练的资金投入和专业性要求。

Deep Speed Chat具备三大核心功能:强化推理、RLHF模块和RLHF系统。其中,强化推理功能通过简化训练流程,使得用户只需一个脚本即可完成多个训练步骤。此外,该工具还提供了一个易于使用的推理API,便于用户在模型训练后测试对话性能。

RLHF模块和RLHF系统则确保了模型训练过程中的精细度,并实现了模型训练与推理能力的无缝切换。

多位业内人士认为,微软的这一举措将显著降低大模型训练门槛,推动人工智能技术的普及。

有业内人士戏称,如果说GPT引发了诸多行业的“工作危机”,那么Deep Speed Chat则可能将这场危机引入人工智能行业本身,促使行业内部进行更加深入的变革。

人工智能商业化领域迎来变革

这一消息无疑将对整个人工智能领域的商业化产生深远影响。

过去几个月,随着ChatGPT的走红,类似Deep Speed Chat的训练开发工具如雨后春笋般涌现。然而,由于缺乏支持端到端的基于RLHF的规模化系统,这些工具在训练ChatGPT模型时的整体效率并不高。

有媒体此前调查发现,现有的开源系统训练效率通常远低于机器所能达到的最大效率。而微软的Deep Speed Chat的面世,或许将大幅改善这一情况。

在Azure云上,训练一个OPT-13B模型(一种类似于GPT系列的大型语言模型)仅需9小时,OPT-30B模型也只需18个小时,且训练成本相对较低。即便是当前开源领域参数最大的OPT-175B,训练时长也仅需20个小时,训练价格也在5000美元左右。要知道,此前千亿参数级别的模型训练成本均在百万级美元以上。

对于微软此次推出的这一重磅服务,有业内人士将之比喻为几十年前家庭电脑的普及。他们认为,正是这种基础建设的普及,推动了整个互联网时代的到来。而如今,随着Deep Speed Chat等工具的推出,一场新的基础建设浪潮已经拉开帷幕。

(文章来源:上海证券报)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。